AB客

AB客 2019-10-29 00:00

2019-10-29 00:00

来自一位在谷歌工作15年的对话:如果非要问我在谷歌工作的15年里学到了什么,那一定是这句话:人们的好奇心是永无止境的。我们每天都会看到数十亿次的搜索,其中15%的查询是我们以前从未见过的——所以我们建立了一些方法来展示这些无法预料的查询。

当这样的人来搜索时,我们并不总是很确定查询的最佳方式。我们可能不知道如何使用正确的拼写单词,或者如何拼写一些东西,因为很多时候,我们来搜索是为了学习——我们不一定自身一开始就有这些知识。

搜索的核心是理解语言。我们的工作是弄清楚你在搜索什么,并从网上找到有用的信息,无论你如何拼写或组合你的关键词。虽然多年来我们不断提高我们的语言理解能力,但有时我们仍然不能很好地理解它,特别是在处理复杂的或非正式的语言查询时。事实上,这就是为什么人们经常使用“关键字-ese”的原因之一,即键入他们认为我们能理解的字符串,但并不是他们确切要问的问题。

我们的研究团队在语言理解科学方面取得了最新进展:

机器学习使这一切成为可能——我们在理解搜索的方式上取得了显著的进步,这是过去五年里最大的飞跃,也是搜索历史上最大的飞跃之一。

将BERT模型应用于搜索:

去年,我们引入并开源了一种基于神经网络的自然语言处理(NLP)预训练技术,我们也称之为:BERT。简洁的说,这项技术可以让任何人建立自己的最先进的自动问答系统。

这项突破性的成果是谷歌transformers模型研究结果,处理一个句子中所有单词之间的关系,而不是一个接一个地处理。

因此,BERT模型可以通过查看上下文的所有单词来考虑完整语义,这对于理解搜索查询背后的意图特别有用。

但使这一成果成为可能的不仅仅是软件上的进步:我们也需要新的硬件。我们可以用BERT构建的一些非常复杂的模型,但是也挑战了我们传统硬件的极限,所以我们第一次使用最新的云计算cpu来提供搜索结果,并迅速为您提供更多相关信息。

破解你的搜索:

有很多技术细节,但这对你来说意味着什么呢?通过将BERT模型应用于搜索中的排名和特色摘要,我们能够更好地帮助你找到有用的信息。

事实上,当涉及到排名结果时,BERT将帮助搜索引擎更好地理解美国1/10的搜索,随着时间的推移,我们将把这一点引入更多的语言和地区。

特别是对于较长的、会话性较强的搜索,或者在“for”和“to”等介词对意思很重要的情况下进行搜索时,搜索引擎将能够理解查询语句中的上下文。你可以用一种你觉得很自然的方式来进行搜索。

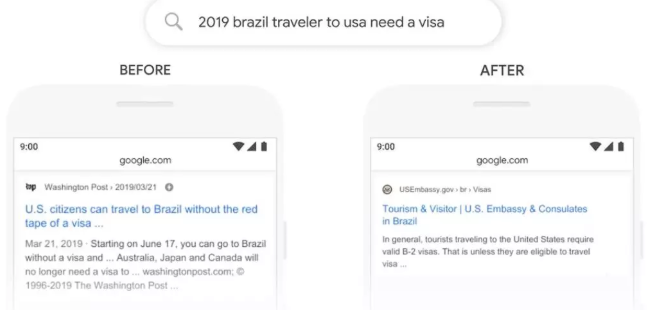

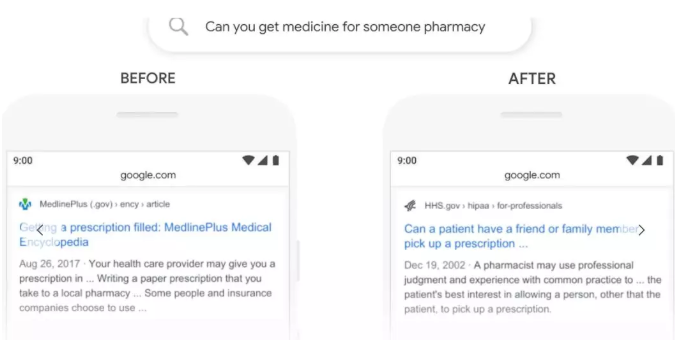

为了启动这些改进,我们做了大量测试,以确保这些更改实际上更有帮助。这里有一些例子展示了我们的评估的过程,证明了BERT理解你搜索背后意图的能力。

以下是“2019 brazil traveler to usa need a visa”的搜索结果。“to”这个词以及它与查询中的其他词之间的关系对于理解语义非常重要。

这是关于一个巴西人去美国旅行的故事,而不是反过来。在此之前,我们的算法无法理解这种联系的重要性,因此我们同样也返回了美国公民前往巴西的结果。(andy老师备注:之前的算法中,介词是无任何意义的)。

有了BERT, 搜索引擎能够把握这种细微差别,并且知道非常常见的单词“to”在这里实际上非常重要,我们可以为这个查询提供更相关的结果。

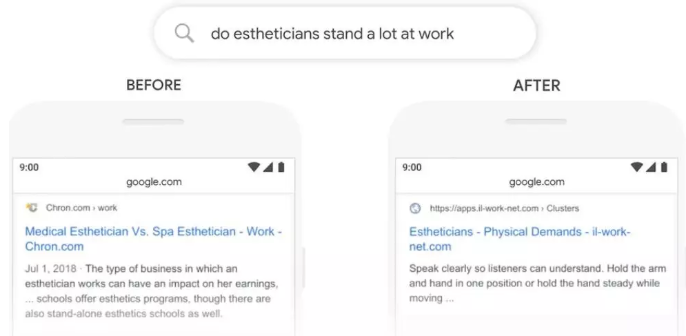

让我们来看看另一个问题:“do estheticians stand a lot at work?”,以前,我们的系统采用的是匹配关键字的方法,将结果中的“stand-alone”与查询中的“stand”匹配。但这不是“stand”这个词在语境中的正确用法。另一方面,我们的BERT模型理解上下文,“stand与”work",这是一种肢体动作,并给出了更有用的搜索结果。

这里有一些其他的例子,BERT帮助我们掌握了语言的细微差别,这些细微差别是计算机无法像人类那样能够完全理解的。

使用BERT模型,我们可以更好地理解“for someone”是这次搜索的重要部分,而以前搜索引擎会直接忽略了它的含义。

谷歌的算法进一步优化,我们在做谷歌SEO的策略也需要再次调整,另外祝大家在外贸路上越走越远,能挖掘道更多的客户,成交更多订单。早日加外贸精英社,和外贸精英们一起成长

扫一扫,关注“外贸精英社”,回复“资料”免费领取外贸进阶资料